인간과 인공지능 행위자의 적절한 관계

AI 에이전트는 과연 AGI가 되어 인류를 위협할까?

우리가 디스토피아적 시나리오가 현실화되지 않는다고 자신 있게 말할 수 있을 때, 시민성은 온전히 보존될 수 있다.

마티아스 리스 (박성진 역), <AI 시대의 정치이론>

AI 윤리 뉴스 브리프

2024년 5월 둘째 주

by 🤔어쪈

목차

1. AI가 읽는 AI가 쓴 자소서

2. (미국이 뽑은) 생성형 AI의 12가지 그림자

3. AI 에이전트를 쓰고 싶지만, 대하고 싶진 않다면?

4. 더 이상 실존하지 않는 인류의 실존 위협 연구소

1. AI가 읽는 AI가 쓴 자소서

2. (미국이 뽑은) 생성형 AI의 12가지 그림자

3. AI 에이전트를 쓰고 싶지만, 대하고 싶진 않다면?

4. 더 이상 실존하지 않는 인류의 실존 위협 연구소

1. AI가 읽는 AI가 쓴 자소서

- 어떤 내용의 글이든 막힘없이 휘뚜루마뚜루 써내는 생성형 AI 기술이 알게 모르게 깊이 침투한 곳이 있습니다. 바로 채용 시장입니다. 구직자 입장에서 구인 공고에 맞춰 수없이 많은 지원서를 써야 하는 번거로움을 줄여주니 마다할 리 없지요. 덕분에 기업들은 지원자 수가 훨씬 증가했다고 합니다.

- 이는 사람을 구하는 회사 입장에서 꼭 좋은 일만은 아닙니다. 서류 심사 대상이 많아진 만큼 검토 업무가 늘어났고, 심지어 지원서에 적은 내용을 면접에서 확인할 수 없는 경우도 종종 발생하고 있습니다. 때문에 생성형 AI로 작성한 서류를 탐지하기 위한 AI를 도입하는 중이죠.

- 한 국내 기업은 작년 하반기 자사 AI 서류평가 솔루션으로 분석한 약 27만 건의 자기소개서 중 11% 이상이 ‘챗GPT를 표절했다고’ 주장합니다. 95%의 정확도를 자랑하지만 22%의 오탐지율은 분명 낮은 수치가 아닐텐데요. 특히 오탐지된 지원서를 기업이 그대로 불합격 처리할 경우, 지원자 입장에서는 공들여 쓴 서류가 단지 AI가 썼다고 의심된다는 이유만으로 탈락하는 상황이 발생할 수 있습니다. 생산성을 높인다는 명목으로 도입한 AI지만 생산성 증대는 커녕 애먼 피해자만 속출하는 것은 아닐까 우려됩니다.

2. (미국이 뽑은) 생성형 AI의 12가지 그림자

- 여러모로 미국의 AI 정책의 열쇠를 쥐고 있는 NIST (미 국립표준연구소) 에서 AI에 대한 4개 문서를 연달아 발표했습니다: 1) AI 위험 관리 프레임워크의 생성형 AI 프로파일; 2) 생성형 AI 및 파운데이션 모델의 안전한 소프트웨어 개발 프레임워크; 3) 합성 콘텐츠의 위험 완화 방안; 4) 글로벌 AI 표준 논의 참여 방안. 모두 작년 백악관이 발표한 AI 정책 행정명령의 후속 조치로, 미국 정부는 NIST에 AI 안전성, 보안성, 신뢰성 확보를 위한 가이드라인과 표준, 우수 사례 마련을 맡긴 바 있습니다.

- 이 중 첫번째 문서를 좀 더 살펴볼까요. 위험 기반 접근법 (risk based approach) 이 사실상 AI 규제의 방법론적 기준으로 자리잡으면서 AI의 위험을 어떻게 평가할 것인지가 관건이 되었습니다. 미국은 일찌감치 NIST에서 AI 위험 관리 프레임워크(Risk Management Framework; AI RMF)를 만들어 국제 표준을 제시하려고 하는 중이죠. 이번에 발표한 ‘생성형 AI 프로파일’은 AI RMF를 AI의 하위 분류 기술에 적용한 첫 사례 보고서입니다.

- 해당 문서에서 식별한 생성형 AI의 12개 주요 위험(허위 정보 및 유해 콘텐츠 생성, 프라이버시 및 지적재산권 침해 등)은 대부분 우리에게 익숙한 것들이지만, 첫번째로 화생방 및 핵무기 정보 제공 문제를 앞세운 것은 눈에 띱니다. 또한 NIST가 여러 종류의 위험을 어떻게 구분했는지, 또 해당 위험 완화를 위해서 어떤 조치가 필요하다고 언급하는지 미리 살펴보는 것만으로도 향후 AI 규제와 표준이 어떻게 자리잡을지 예상해 볼 수 있을 것으로 보입니다.

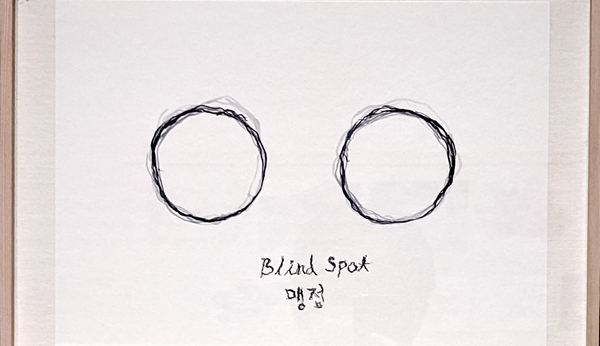

3. AI 에이전트를 쓰고 싶지만, 대하고 싶진 않다면?

- 현재 AI 업계에서 가장 뜨거운 키워드를 고르라면 단연 ‘AI 에이전트 (agent)’일 겁니다. 최근 오픈AI CEO 샘 알트만 역시 최근 인터뷰에서 완성도 높은 AI 에이전트가 킬러 앱이 될 것이라고 언급했듯, 많은 기업이 생성형 AI 기술을 앞세워 AI 에이전트 개발에 여념이 없습니다. 하지만 소셜미디어의 봇 계정, 게임의 NPC (비플레이어 캐릭터), 고객센터의 ARS (자동응답시스템) 를 떠올려보면 AI 에이전트는 사실 새로운 것이 아닙니다.

- AI 에이전트는 지능형 또는 생성형 ‘행위자’로 직역되기도 하는데, 이는 곧 사람이 할법한 말과 행동을 대신할 수 있다는 의미를 함축합니다. 많은 AI 회사가 ‘당신이 [더 중요한 일]에 집중할 수 있도록 [특정 행위]는 AI에게 맡기세요’라고 속삭이고, AI 에이전트의 사용자에게 이는 분명 솔깃한 제안입니다. 하지만 기업도 사용자도 놓치기 쉬운 부분은 그 [특정 행위]가 AI 에이전트를 직접 마주할 다른 사람들에게는 [더 중요한 일]일 수 있다는 사실입니다.

4. 더 이상 실존하지 않는 인류의 실존 위협 연구소

- 우리에겐 <슈퍼인텔리전스 (Superintelligence)>라는 책 저자로 유명한 닉 보스트롬(Nick Bostrom)이 이끌던 옥스포드 인류미래연구소 (Future of Humanity Institute, 이하 FHI) 가 문을 닫았습니다. 19년간 명맥을 이어온 것에 비해 다소 조용한 마지막이었습니다. 기존 홈페이지는 종료 안내와 검색창만 남긴 채 사라졌고, 조촐한 아카이빙 웹사이트만 남았습니다.

- FHI는 철학과 소속이었지만 특정 학문 분과보다는 비슷한 사상, 특히 효과적 이타주의 (effective altruism) 나 장기주의 (longtermism) 에 기반한 연구소였습니다. 연구소장 닉 보스트롬의 초지능 담론을 비롯한 인류에 대한 실존적/파국적 위험 (existential-catastrophic risk) 이나 인간증강 (human enhancement) 과 같은 주제를 비교적 일찍이 다뤄왔고, 특히 실리콘밸리의 주목과 후원 아래 초지능 내지는 AGI (인공일반지능) 의 위험 담론을 주도해왔습니다.

- 때문에 FHI에서 태동한 사상은 현재의 AI 안전과 AI 거버넌스라는 이름으로 AI 윤리 논의에 적잖은 영향을 미치고 있습니다. 하지만 AI 윤리 레터에서도 초기부터 지적해왔듯, 그 추종자들이 당장의 AI 기술이 가진 문제점 대신 먼 미래에 대한 사고실험에만 관심과 자원을 쏟도록 유도하고 있어 주의해야 합니다. FHI의 유산에 대해 비판적인 평가가 필요한 이유입니다.

📆

소식

- 그.래.서! 이번 5월 21일(화)부터 AI 윤리 북클럽은 <AGI 담론 비판>을 주제로 시즌 2를 진행합니다. AI 윤리 레터를 통해 종종 읽은 글과 논의한 내용을 전해볼게요!

- 그.래.서! 이번 5월 21일(화)부터 AI 윤리 북클럽은 <AGI 담론 비판>을 주제로 시즌 2를 진행합니다. AI 윤리 레터를 통해 종종 읽은 글과 논의한 내용을 전해볼게요!

#feedback

오늘 이야기 어떠셨나요?

여러분의 유머와 용기, 따뜻함이 담긴 생각을 자유롭게 남겨주세요.

남겨주신 의견은 추려내어 다음 AI 윤리 레터에서 함께 나눕니다.