모델을 넘어, 한국을 넘어

모델 안전을 넘어서는 AI 안전, 한국을 넘어서는 동아시아 AI 윤리

파멸doom이란 무엇인가? 관습적으로 파멸은 법령 또는 조례, 즉 지시다. 파멸은 또한 심판, 법, 판단 능력, 세계의 끝 이후에 벌어지는 최종 심판을 의미한다. 그렇지만 파멸은 또한 우리가 생각하는deem 것, 즉 의견이나 분별이다. 파멸은 숙명, 운명, 더 강력한 의미로는 죽음을 뜻할 수 있다. 최종적으로 파멸은 정의, 심지어 정의를 시행하는 재판관을 의미한다.

—티모시 모턴 (김지연 옮김), <하이퍼객체>

1. 모델 안전을 넘어선 AI 안전의 필요성

2. 동아시아 지역의 AI 윤리가 궁금한 사연

모델 안전을 넘어선 AI 안전의 필요성

by 🤔어쪈

지난주 저명한 정치경제학자 대런 애쓰모글루(Daron Acemoglu)가 쓴 ‘AI 안전성 논의가 아예 잘못되었다(The AI Safety Debate Is All Wrong)’는 도발적인 제목의 칼럼이 눈길을 끌었습니다. 올해 초 AI 윤리 북클럽에서 읽은 <권력과 진보> 저자이기도 한 그는 사실 비교적 일찍부터 AI에 관심을 가지며 기술의 경제적 함의를 연구한 바 있는데요. 이번에 쓴 글에서 나타난 그의 입장은 놀라우리만치 AI 윤리 레터에서 지적해 온 내용과 비슷했습니다.

글을 간단히 요약하자면 이렇습니다.

- 현재 AI 안전성 논의는 AGI의 잠재적인 파멸 위협에 과도하게 집중하고 있어 기술 개발 및 사용 주체의 의도나 권력 구조를 간과한 채 AI 모델의 정렬(alignment) 문제 해결에만 초점을 맞추고 있음

- 이는 AI의 불필요한 의인화를 넘어 이미 발생중인 실질적인 위험 방지에 도움이 되지 않으며, AI 산업에 대한 과장 광고 효과로서 투자와 인재 유치에만 도움이 될 뿐임

- AI 안전성 논의는 주요 AI 개발 및 사용 주체이자 권력을 가진 기술 기업과 정부를 견제할 수 있는 제도적 장치에 대한 시민 요구로부터 다시 출발해야 함

이른바 AGI 논쟁은 AI 윤리 레터의 시작부터 함께해 온 주제입니다. 뉴스레터 초기부터 지금의 기술 기업들의 정반대편에 서있는 팀닛 게브루를 소개하고, AGI가 가리고 있는 현실을 보자고 말해왔죠. AI 하이프 뉴스 체크리스트를 만들어 AI 윤리 논의를 혼탁하게 만드는 과장 광고에 대한 경각심을 불러일으키기도 했습니다. 겉보기에 마술처럼 느껴지기도 하는 AI가 실제로는 어떻게 학습되고 작동하는지를 다루고, 미래가 아닌 지금 바로 여기서 나타나는 문제들을 지적했습니다. 최근에는 AGI를 주제로 북클럽도 진행하여 성황리에 마무리했습니다.

하지만 대런 애쓰모글루와 AI 윤리 레터가 계속해서 지적해온 AGI 논쟁을 차치하고서라도 저는 여전히 지금의 AI 안전성 논의가 잘못된 길에 들어섰다고 생각합니다. 바로 ‘단일 AI 모델’에 초점을 맞추고 있다는 점 때문입니다.

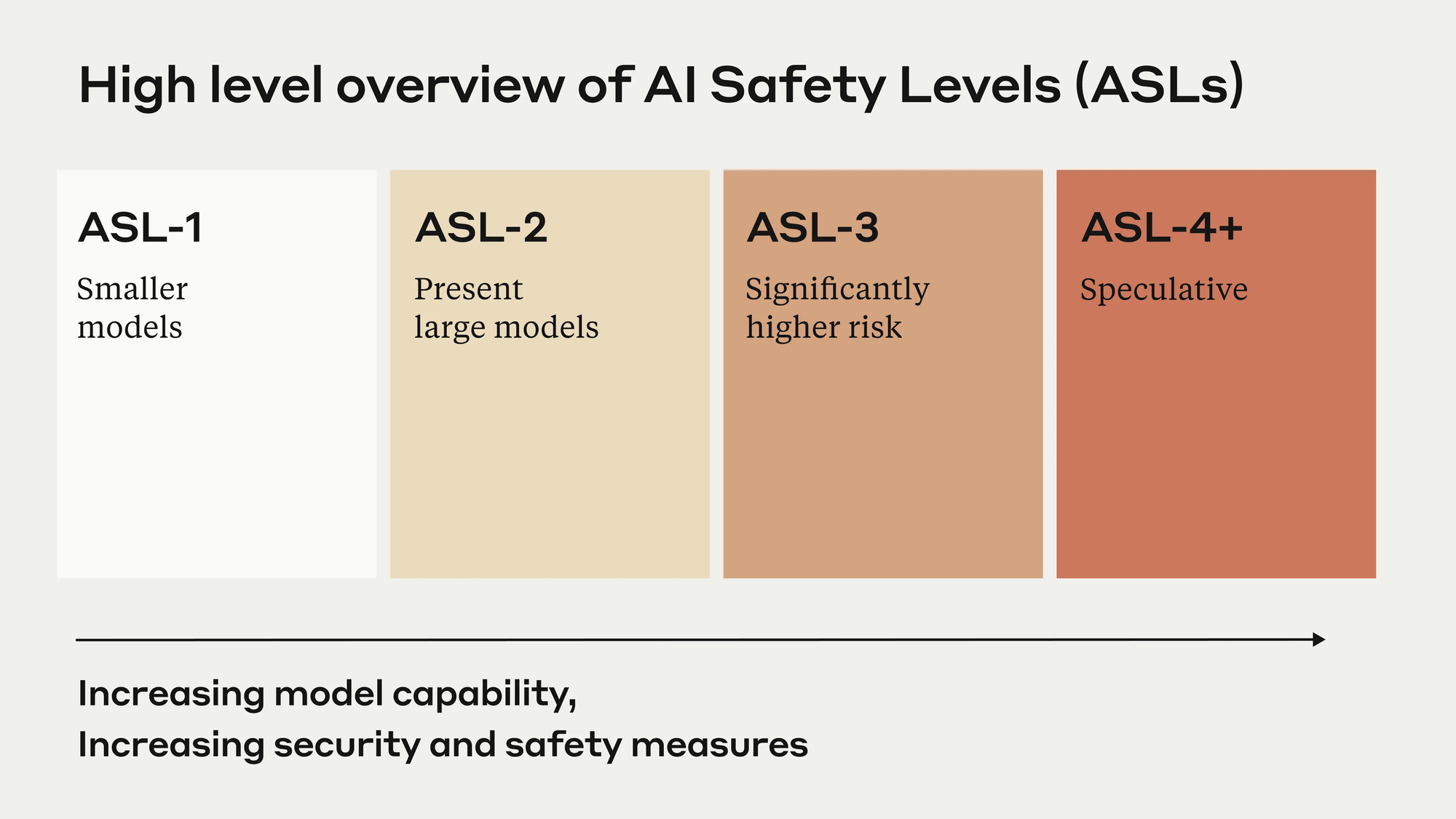

AI 안전이라는 주제가 기술적 문제 해결에만 천착하는 문제는 이미 지난 레터를 통해 다룬 바 있습니다. 하지만 자세히 살펴보면 기술적 문제 역시 충분히 다루고 있다고 하기 어렵습니다. 오픈AI, 구글, 앤스로픽, 네이버 등 AI 기업들이 내놓은 AI 안전성 프레임워크는 하나같이 GPT-4o, Gemini 1.5 Pro, Claude 3 Opus 등 그들이 개발한 최신 AI 모델의 위험성 평가를 주요 내용으로 담고 있습니다. 여기서 말하는 위험성 평가란 해킹 문제를 풀 줄 아는지, 생화학 무기 관련 정보를 제공하는지, 사용자를 속일 수 있는지 등을 의미합니다. AI 정렬 문제란 거창하게는 AI가 인간 사회의 가치를 따르도록 하는 것이지만, 실상은 챗봇이 어떤 말을 하지 못하도록 할 것인지가 핵심입니다. 대런 애쓰모글루가 지적한대로 과도한 의인화로 인해 AI 안전이 너무 축소된 모습이죠.

단일 AI 모델을 대상으로 한 평가는 최신 AI 연구 및 산업 동향과도 동떨어져있습니다.

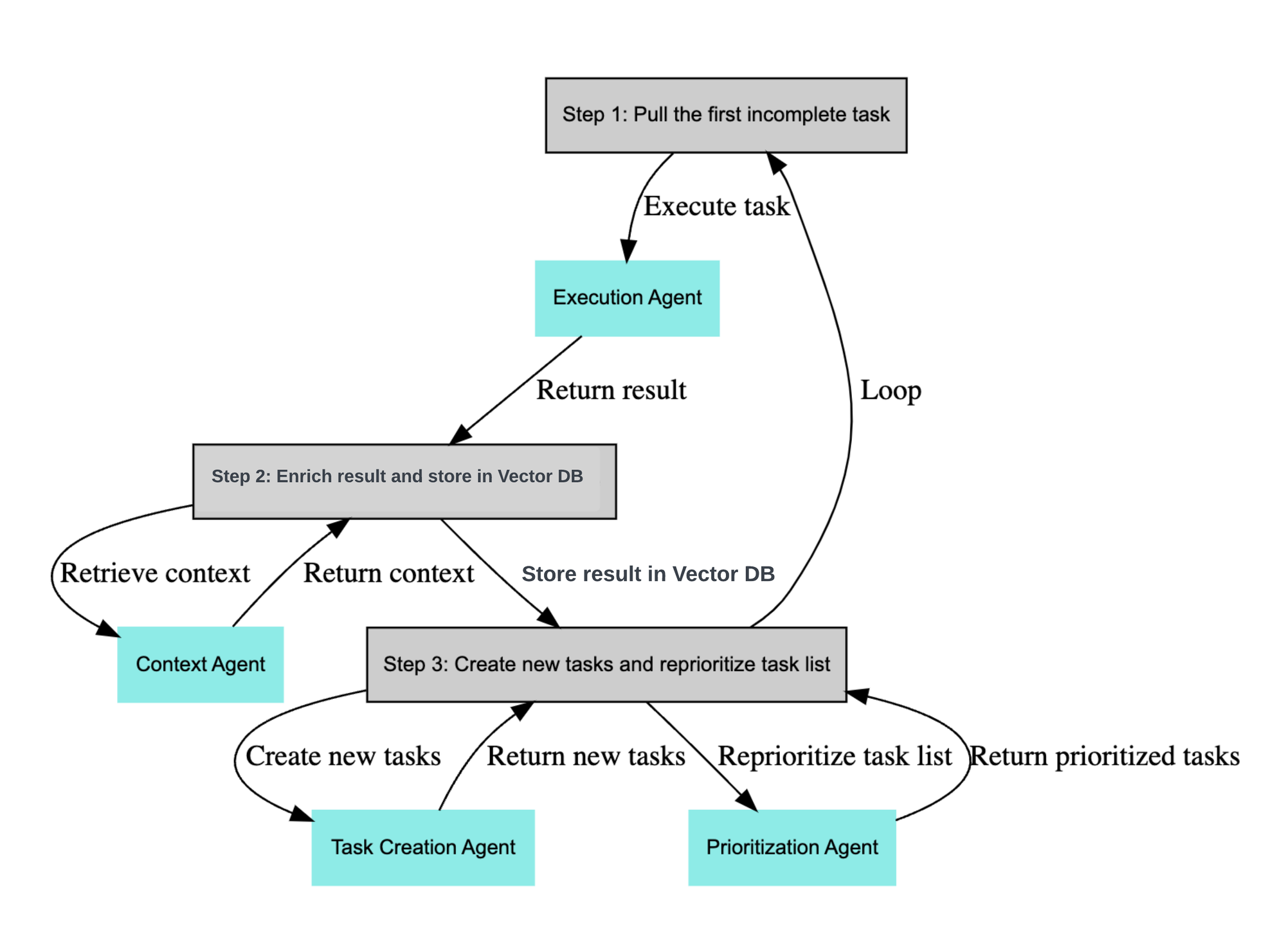

요즘 AI 업계의 키워드인 AI 에이전트 내지는 에이전트 워크플로우(agentic workflow)는 하나 이상의 AI 모델로 시스템을 구성하는 것을 전제합니다. 위 도식을 예로 들자면, 실행 (Execution), 맥락 제공 (Context), 작업 생성 (Task Creation), 우선순위 설정 (Prioritization) 등의 모듈 각각에 AI 모델이 위치하여 에이전트로 기능하는 것이죠. 실제로 많은 서비스가 이러한 구조를 바탕으로 만들어지고 있습니다. 이처럼 다소 복잡한 구조의 ‘시스템’으로서의 AI 서비스를 두고 단일 AI 모델만을 AI 안전 평가 대상으로 삼는 것을 효과적이라고 보긴 어렵죠. 실제로 복수의 AI 모델을 활용하면 개별 AI 모델로는 불가능하던 위험한 일을 수행할 수 있다는 연구 결과도 있습니다.

우리가 살아가면서 사용하는 많은 종류의 기술들 중 단일 객체로 구성된 사례는 거의 없습니다. 대부분 여러 모듈로 구성된 시스템이죠. AI 역시 마찬가지입니다. 단일 AI 모델이 부적절한 출력을 하지 못하도록 막고서 안전하다고 홍보해도, 여러 개의 AI 모델과 다른 기술들을 활용해 만든 복합적인 시스템은 안전하지 못한 상황이 발생할 수 있습니다. 요컨대 AI 안전성은 모델 안전성을 넘어서야만 합니다.

이렇게 모델이 아닌 시스템을 보면서 AI 안전에 대한 시야를 넓히면 시스템이 기술로만 구성되는 것도 아님을 어렵지 않게 알 수 있는데요. 다음에는 이처럼 AI 안전을 보다 확장된 시각으로 이해하고자 하는 사회기술적 접근 방식에 대한 논의를 소개해드리도록 하겠습니다.

동아시아 지역의 AI 윤리가 궁금한 사연

by. 🤖아침

AI 기술과 사회의 관계에 주목하는 뉴스레터를 1년 남짓 운영하며 줄곧 느끼는 갈증이 있습니다. 내가 사는 한국, 좀 더 넓게는 동아시아 지역에 발을 디딘 비판적/대안적 AI 담론이 부족하다는 것입니다.

갑자기 웬 푸념? 조금 부연해보겠습니다.

AI 기술에 관련된 이야기는 흔히 서구-영어권을 위주로 서술됩니다. 이 세계관의 중심에는 미국 실리콘밸리, 기술적 혁신이 흘러나오는 곳이 있습니다. 또다른 주연급인 EU는 법규제 등 제도적 장치를 선도하는 역할이고, 중국은 기술개발과 제도 측면에서 모두 발빠르지만 속내를 알 수 없는, 사실상의 적대 진영으로 자리합니다.

이 세계관에서 한국을 포함한 여타 국가에게 중요하다 여겨지는 것은 위 국제질서 속에서 생존하는 일입니다. 서구 기업과 적극 협력하거나, 아니면 실리콘밸리 자본에 잠식되지 않는 독자 경쟁력을 확보하기 위해 자국 산업을 육성하며 자국민을 보호할 수 있는 규제를 마련하거나, 기본 전제는 비슷합니다. 즉 기술은 서구에서 나와 비서구로 전파되거나, 비서구에서 따라잡아야 하는 무언가라는 것입니다.

물론 이는 지나치게 단순한 관점입니다. 기술은 서구에서만 만들어지는 것이 아니며, 일방적으로 '전파'되는 것도 아닙니다. 각 지역의 기술 개발은 서구 기술의 단순한 '이식'이 아니라 다양한 사회적 관계 속에서 이루어집니다. 여러 비판적 연구, 언론 보도, 활동가의 개입 덕분에 우리는 아프리카나 동남아시아의 저임금 노동이 AI용 데이터를 만들고, 컴퓨팅 인프라를 위한 광물이 세계 각지에서 채굴되는 의존 관계를 이미 알고 있습니다.

이같은 비판적 담론은 수행하는 중요한 역할 하나는 AI 기술이 기존 권력 구조를 강화 재생산하는 방식을 보여줌과 함께 남반구 세계(제3세계/다수세계 등으로 불리기도 하는)의 관점을 드러내어, 서구 중심의 AI 세계관에 균열을 내는 것입니다. AI를 둘러싼 개념을 다양한 관점에서 재정립하는 작업(사례1, 사례2), 참여-개입-연구의 경계를 넘나드는 활동(사례1, 사례2), 비-서구에 초점을 맞춘 언론 활동 등 다양한 방면에서 이같은 노력이 이루어집니다.

하지만 [서구 - 남반구]로 확장된 구도에서도 한국 같은 지역은 다소 모호한, 희미한 영역으로 남아 있다고 느낍니다. 왜 이런 기분이 들까요. AI 기술 개발뿐만 아니라 기술 비판 담론 역시도 서구-영어권을 주축으로 활발한 조건 속에서, 한국 등지에 주목하는 비판적 AI 논의가 실제로 충분하지 않을지도 모릅니다.

한편, 이곳을 기반으로 힘쓰는 연구자, 기술 종사자, 교육자, 활동가, 창작자, 언론 종사자, 정책전문가 등이 존재한다는 사실 또한 분명합니다. 실제로 이들의 노력 덕에 노동, 교육, 기후 등 AI를 둘러싼 여러 이슈에서 사회적 대화가 풍부해지고 있고요. 그러니까 제가 국내 논의에 아직 과문해서 부족함을 느끼는 부분도 있겠지요. 이 뉴스레터 역시도 서구나 남반구의 관점을 소개하는 데 그치는 게 아니라, 이곳에서 이루어지는 논의를 찾아 배우고 연결하는 시도의 일환이라고 할 수 있고요.

그럼에도 아쉽습니다. AI 관련 논의가 사회적 가치보다 산업 육성, 국제 경쟁, 트렌드 적응 같은 것에 쏠려 있기 때문만은 아닙니다. 그건 한국뿐만 아니라 어디서나 나타나는 보편적인 현상에 가깝습니다. 이에 대한 비판적 개입은 물론 필요하지요. 하지만 ‘이곳’, 한국 그리고 나아가 동아시아의 이야기가 획기적으로 더 필요하다고 느끼는 이유가 있습니다.

지역적 현실에 충분히 발딛지 못한 기술 비판 담론은, 주류 질서에 대안을 제시하기보다 오히려 그것에 편취될 위험을 갖는 것 아닐까요? 예컨대 AI 윤리/안전 분야 일각에서 ‘다양성’이라는 키워드가 ‘AI 주권 확보’를 위해 국내 산업을 육성해야 한다는 주장의 근거로 동원되거나 ‘리터러시’ 개념이 ‘AI 서비스 사용자 비중’으로 환원되는 양상을 보며, ‘AI 윤리’가 정치안보/경제 논리를 맞닥뜨릴 때 어떤 효력을 가질 수 있을지 걱정됩니다.

다시 말해 앞서의 서구 중심 AI 세계관이나 거기서 뻗어나오는 발전주의 논리가 AI 윤리 논의를 포섭하여 무력화할 위협이 있으며, 이 위협에 대응하는 방식 중 하나는 지역적 현실에 최대한 구체적으로 자리잡는 것이 아닐까 싶습니다.

여기에 하나 덧붙이자면, 국경의 테두리 안에서만 진행되는 논의 역시 (그간의 비판적 담론이 보여주듯 현실과 부합하지 않을 뿐더러) 개별적 국가 내부의 사회적 이슈로만 머물러서는 '발전주의'를 극복하기 어려울 것 같습니다. 유사한 일이 벌어지고 있는 다른 곳의 사정을 파악하고, 그곳의 비판적 목소리와 이곳의 목소리를 연결하고 확장하는 일이 필요해 보입니다.

지역적 맥락을 구체화하고, 특정 국가 이상으로 더 넓은 연대를 만들어가는 작업을 통해 국가주의/자본주의적 논리에 따른 AI 발전론을 견제하는 하나의 축을 마련할 수 있지 않을까 합니다. 그리고 이러한 지역적 맥락은 앞서 언급한 서구 및 남반구와의 관계뿐만 아니라 한국과 주변 지역의 위치성과 관계성 측면에서 고민해야 합니다. 달리 표현하자면 이런 것입니다. 독자 피드백 중 종종 ‘이런 문제의식을 공유하는 사람이 주변에 잘 없는데 뉴스레터 같은 공간이 있어서 다행’이라는 요지의 의견을 주시는 경우가 있습니다. 물론 감사한 일입니다. 동시에, 이같은 공간이 더 넓고 깊어지면 좋겠습니다.

첫머리에서 동아시아를 호출한 것은 이런 연유입니다. 거칠게 말하면 한국과 여러 특성을 공유하는 지역에서 AI 윤리 관련 논의를 확장하고 연결할 필요가 있다는 것입니다. 일본, 대만 등을 아우르는 동아시아 공간은 한국과 지정학적 맥락뿐만 아니라 근현대를 거쳐오며 평화, 노동, 환경, 젠더 등 다양한 시민 연대를 실천해온 역사적 맥락 또한 공유합니다. 이같은 조건이 AI 기술에 관한 비판적 논의에서 공통의 지점을 만들어내는 데 도움이 될 수 있을까요. 즉 유사성을 발견하고, 그 과정에서 목소리를 키울 수 있지 않을까요.

앞으로 이런 질문에 대한 답을 얻을 수 있으면 좋겠습니다. 질문 자체도 더 다듬어야 할테고요. 우선 한국뿐만 아니라 동아시아 지역에서 AI 윤리와 관련된 주요 이슈는 어떤 것이 있었는지 찾아보려 합니다. 거창한 취지와 별개로 개인적인 호기심도 있고요. (일본이나 대만 등지에서는 한국의 이루다 이슈 같은 것이 없었을까요?) 이 주제에 관해 조언이나 팁이 있으신 분, 같이 디깅하고 싶으신 분은 연락 주세요.

#feedback

오늘 이야기 어떠셨나요?

여러분의 유머와 용기, 따뜻함이 담긴 생각을 자유롭게 남겨주세요.

남겨주신 의견은 추려내어 다음 AI 윤리 레터에서 함께 나눕니다.